做好时间同步 http://www.dhhblog.com/?p=1164

三台配置好hosts文件

vim /etc/hosts 10.0.0.20 hadoop1 10.0.0.21 hadoop2 10.0.0.22 hadoop3 #hadoop1为主节点 namenode #hadoop2和3为DataNode节点

三台机器要做好免密码互信 http://www.dhhblog.com/?p=1159

下载以下所有东西

https://pan.baidu.com/s/1ouCGECr-mRg5qjXf8WzCqw 提取码:04lv

安装java

#删除掉过去的系统自带的java #先确定是否已经有java安装过 rpm -qa|grep java #如果有的话我们使用rpm -e xxxxxxxxxxxxx(代表你刚才命令执行出的结果内容) --nodeps (不考虑关联删除) rpm -e tzdata-java-2014g-1.el6.noarch --nodeps #将jdk-8u45-linux-x64.tar安装包上传到/usr目录下 cd /usr rz #解压该压缩包 tar xzvf jdk-8u45-linux-x64.tar.gz #改名 mv jdk1.8.0_45/ java #配置环境变量 vim /etc/profile #在尾部添加 export JAVA_HOME=/usr/java export JRE_HOME=/usr/java/jre export CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar:$JRE_HOME/lib export PATH=$PATH:$JAVA_HOME/bin #生成环境变量 source /etc/profile

安装hadoop

#上传hadoop安装包到 hadoop-2.7.3.tar /usr/local下 #解压安装包 rz tar xzvf hadoop-2.7.3.tar.gz #将解压以后的目录改名 mv hadoop-2.7.3 hadoop #配置环境变量 vim /etc/profile#在尾部添加 export HADOOP_HOME=/usr/local/hadoop export LD_LIBRARY_PATH=$HADOOP_HOME/lib/native export HADOOP_COMMON_LIB_NATIVE_DIR=/usr/local/hadoop/lib/native export HADOOP_OPTS="-Djava.library.path=/usr/local/hadoop/lib" export PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin #生成环境变量 source /etc/profile

创建目录

mkdir -p /var/hadoop/tmp

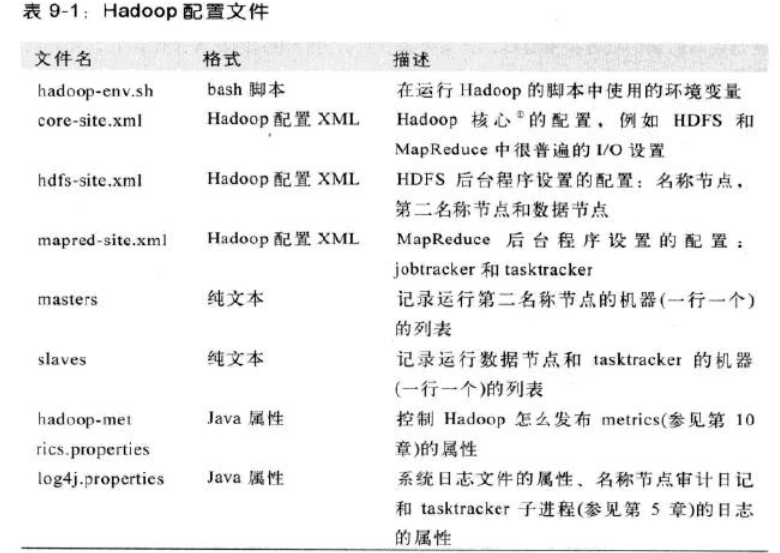

修改hadoop配置文件

cd /usr/local/hadoop/etc/hadoop/

vim hadoop-env.sh #第25行改为 export JAVA_HOME=/usr/java

在两个<configuration>中添加下列内容

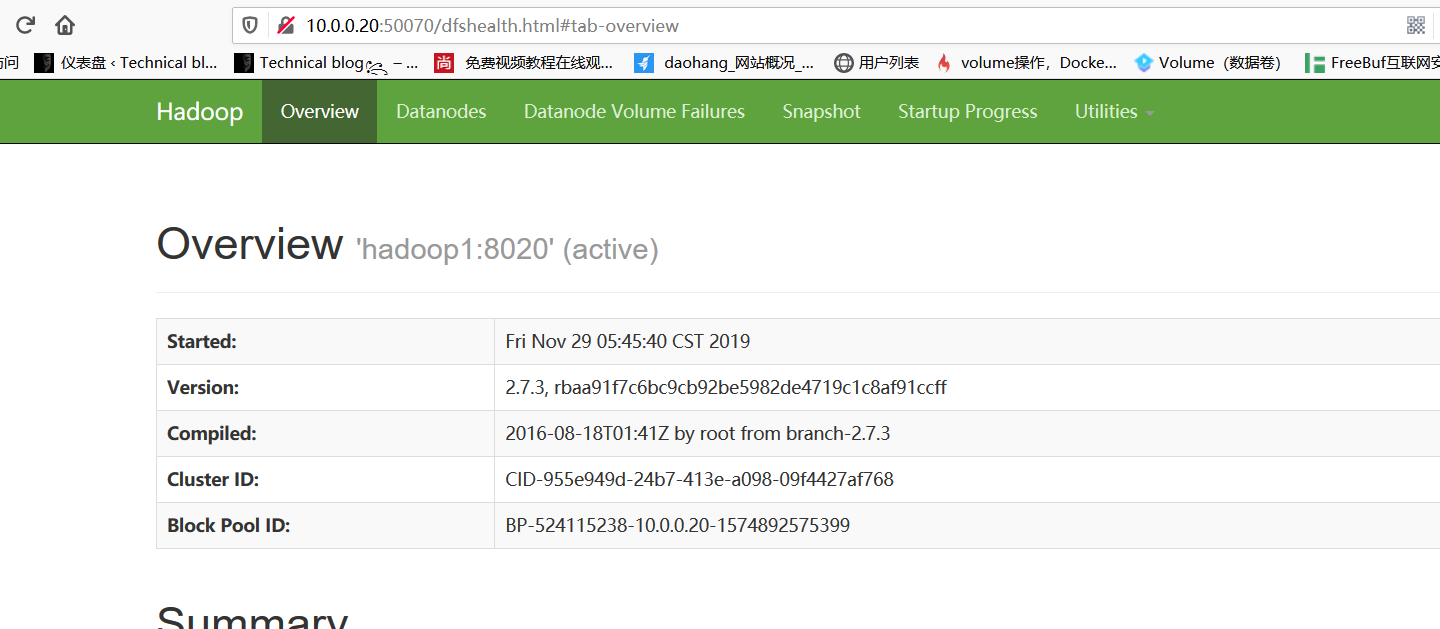

vim core-site.xml <property> <name>fs.defaultFS</name> <value>hdfs://hadoop1:8020</value> </property> <property> <name>hadoop.tmp.dir</name> <value>/var/hadoop/tmp</value> </property>

vim yarn-site.xml

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.resourcemanager.hostname</name>

<value>hadoop3</value>

</property>

#添加DataNode主机名 vim slaves hadoop2 hadoop3

namenode主机将配置好的hadoop拷贝到两台DataNode机器上

scp /usr/local/hadoop/etc/hadoop/* root@hadoop2:/usr/local/hadoop/etc/hadoop/ scp /usr/local/hadoop/etc/hadoop/* root@hadoop3:/usr/local/hadoop/etc/hadoop/

关闭警告

vim /usr/local/hadoop/etc/hadoop/log4j.properties #加到最后 log4j.logger.org.apache.hadoop.util.NativeCodeLoader=ERROR

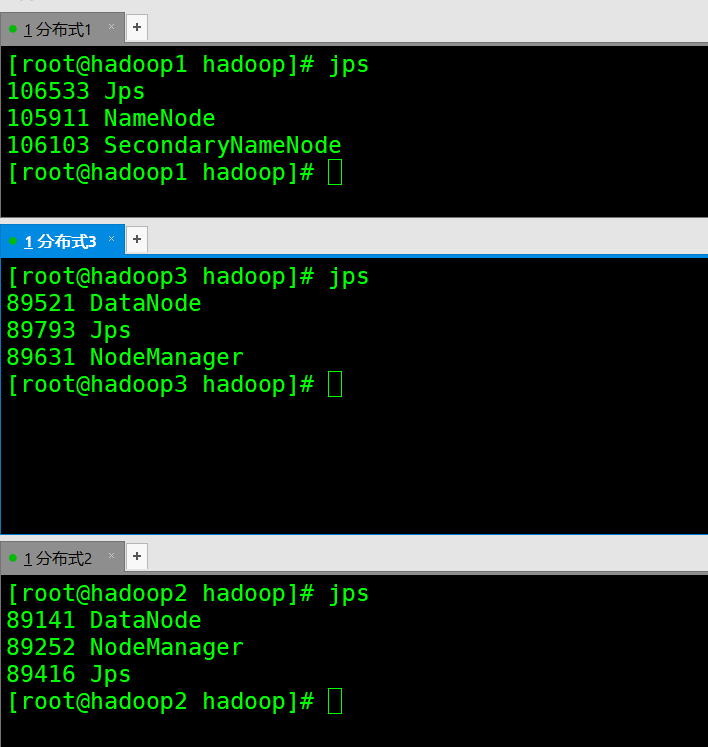

hadoop1格式化,启动hadoop

hdfs namenode –format start-all.sh

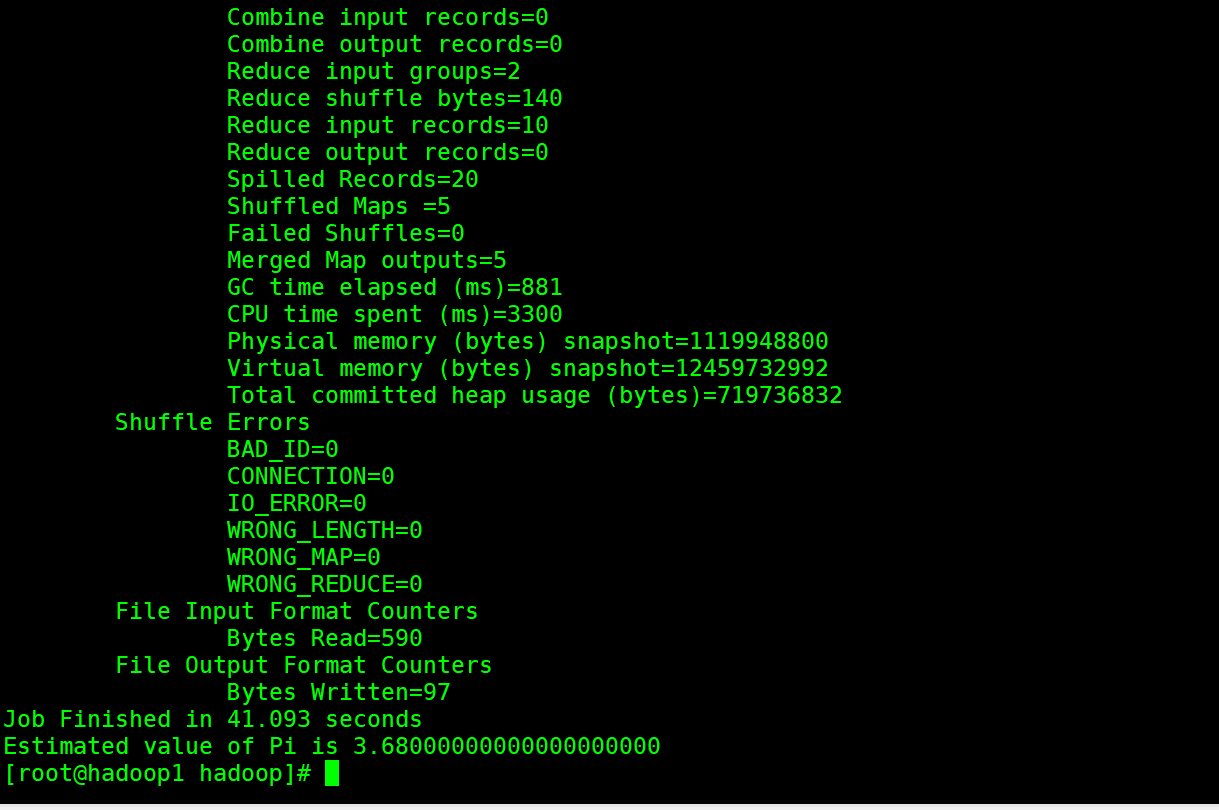

这是hadoop自带的一个小例子,pi是一个参数,可以用来验证Hadoop集群是否成功。

hadoop jar /usr/local/hadoop/share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.3.jar pi 5 5